Home>> Our Business>> Cloud Computing and Big Data>> External Data Integration Platform

AG真人软件股份有限公司基于对金融风险业务的深刻理解,结合公司专业团队丰富的金融软件建设经验与深厚的技术沉淀,研发推出了外部数据整合平台。

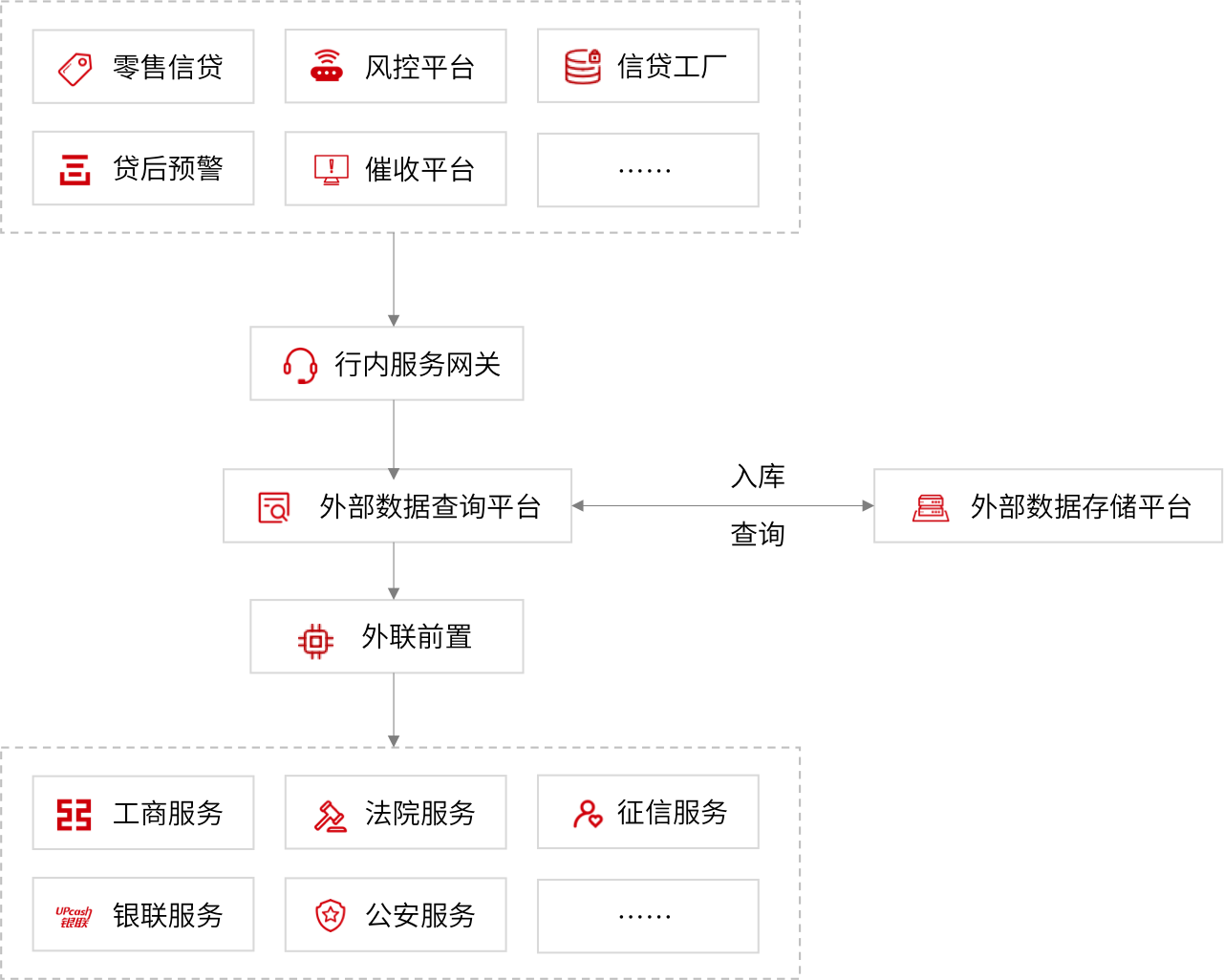

外部数据接入整合平台分四个部分:系统前置、接入层、服务层、接口层。

系统前置主要负责对接外部系统。

接入层负责采集过程中的服务监控、源数据解析入库功能。

服务层基于工商、汇法、公安、税务、万得、易宝支付等各类业务数据进行数据支持和查询服务支持。包含:通用接口、专用接口、特征指标、决策支持、全景视图、模型计算。

接口层以WebService、URL、批量形式提供数据给业务系统。为了能对多台应用服务器资源进行统一调配、同时实现网络的负载均衡,引入“总控”。业务系统所有数据查询请求均通过总控服务器,并通过总控分发至相应的数据查询应用服务器处理。主要实现并发控制、同步通讯、异步通讯、同步转异步、负载均衡、异常管理、访问管理、重试容错功能。

由于外部源数据的分散独立、平台异构、标准不统一、模型差别大、冗余度高等状况,在将其提炼、抽取到外部数据管理平台时必须要进行必要的转换与整合、存储,设计开放的、可扩展的数据模型,利于今后的外部数据整合与应用需求,做到外部数据统一接入、集中存储、服务共享。

基于公司成熟的企业级应用平台IFS实现,采用当前业界主流技术,基于开放平台,切合金融业未来信息技术架构要求,以决策驱动的框架设计,使本产品具备良好的适用性,高度的灵活性和扩展性。

采用国际先进的数据源解析器,针对不同格式的数据源采用不同的解析器,如XML文件使用SAX解析、PULL解析和DOM解析,JSON可以使用缓冲区数据解析后入库。

网络爬虫(Web crawler)是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本,它们被广泛用于互联网搜索引擎或其他类似网站,可以自动采集所有其能够访问到的页面内容,以获取或更新这些网站的内容和检索方式。

设计上应用松耦合的层次结构,分为接入层,服务层,接口层。采用业务组件细分重组方式,耦合度低,可根据业务的不同细分要求进行组件重组,实现插件化的管理,可即插即用。

借鉴商业规则引擎的成熟体系,从业务角度建模,使用富客户端技术操作流畅、遵循友好的人机操作体验为设计原则。通过可视化建模的方式,大幅度降低了操作门槛。

提供用户身份认证、访问权限控制等手段保证高安全性,并具备完善的安全管理体系包括技术管理体系、业务管理体系和内控管理体系,能有效保证客户信息及资料的保密和安全。

在互联网大数据背景下各类营销及风险分析模型对于外部数据的需求也越来越强烈,因此某商业银行组建了全行级的外部数据整合平台,主要内容包括1.接入控制、优先级控制等服务质量保证组件2.外部数据接入3.数据整合4. 单笔、批量查询服务5.原单独业务条线接入的外部数据进行迁移和整合。